Il data mining si è rivelata un elemento rivoluzionario per il business: chi possiede le informazioni, possiede il vantaggio competitivo. Come strumento che accelera il processo di estrazione dei dati, il software di web scraping rappresenta una vera benedizione per marketer o analisti di dati che desiderano trarre informazioni significative da una quantità apparentemente infinita di dati.

Come Funziona il Software di Web Scraping

La maggior parte dei software di web scraping automatizza il processo di raccolta dati da pagine web accedendo al contenuto, estraendo dati specifici e salvando queste informazioni in un formato strutturato come CSV, Excel o un database.

Esistono quattro tipologie principali di software di web scraping: estensioni per browser, applicazioni desktop, software basati su cloud, API o librerie. Alcuni strumenti o piattaforme possono sovrapporsi a più categorie, offrendo soluzioni più complete, ma la maggior parte si specializza in un unico ambito.

Di seguito, ti presenteremo i 30 migliori software o piattaforme di scraping che sono gratuiti o offrono una prova gratuita, con una sintesi della mia esperienza per riferimento, inclusi vantaggi e svantaggi.

Top 30 strumenti gratuiti per lo web scraping

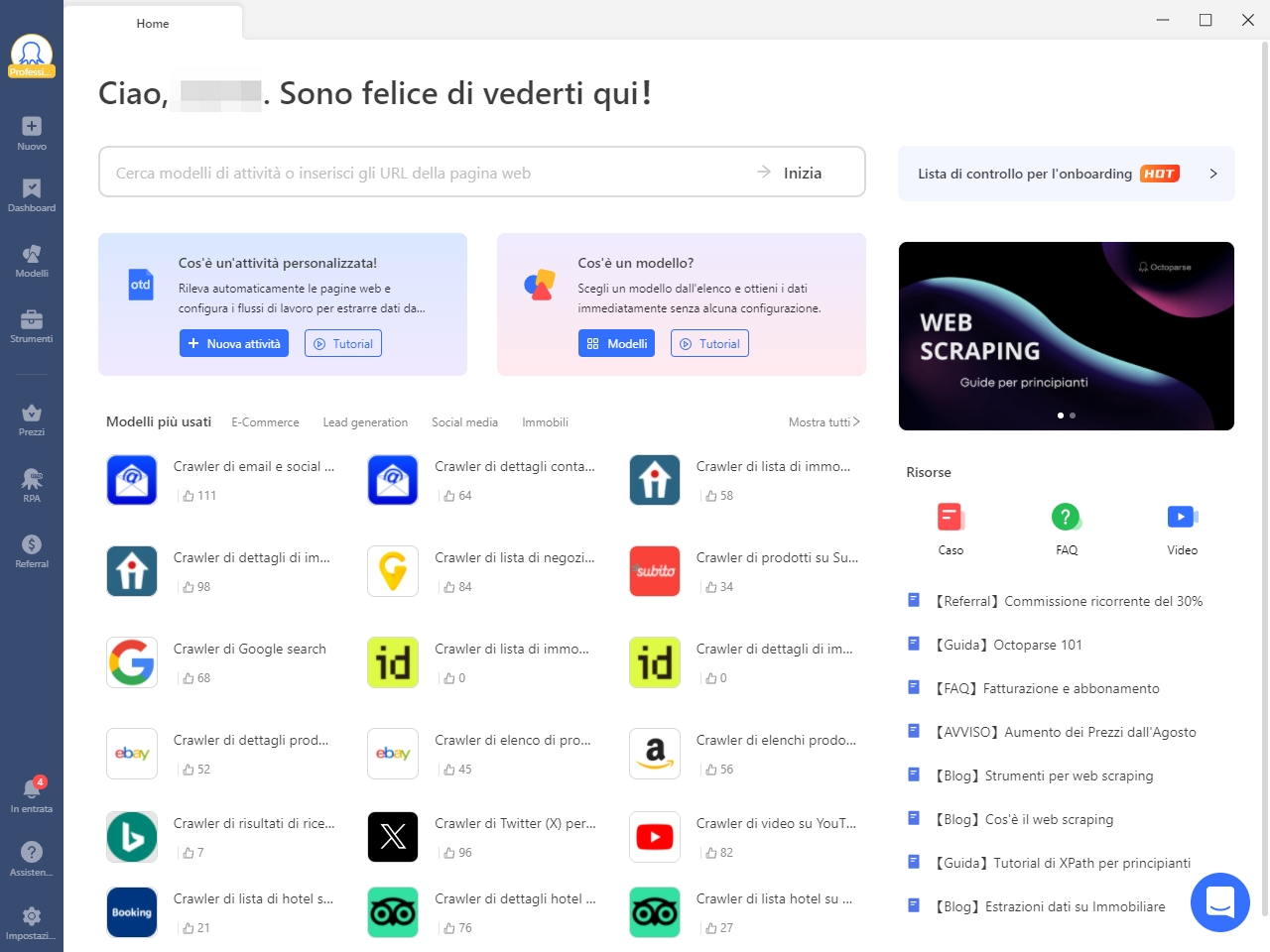

1. Octoparse – Consigliato

A chi serve: tutti quelli senza competenze di programmazione che necessitano di estrarre dati web su larga scala. Il software per il web scraping è ampiamente utilizzato tra venditori online, marketer, ricercatori e analisti di dati.

Cos’è: Octoparse è una piattaforma di dati web SaaS gratuita per la vita. Con la sua interfaccia intuitiva e la funzione di rilevamento aut0omatico, puoi estrarre dati web con punti e clic. Fornisce anche modelli di scraping web pronti all’uso per estrarre dati da Amazon, eBay, Twitter, Subito, ecc.. Se stai cercando una soluzione dati completa, Octoparse offre anche servizi di web data. Oppure, è possibile semplicemente seguire la guida utente di Octoparse per estrarre facilmente dati dal sito web gratuitamente.

Vantaggi:

- Scraper pronti all’uso per tutti i siti web più popolari, non è richiesta capacità di programmazione.

- Servizi personalizzati per scraper e servizi di dati.

- Impostazioni anti-blocco: gestione CAPTCHA, rotazione degli IP, agenti utente, intervalli e login.

- Gestione di siti complessi: scrolling infinito, menu a tendina, hover, retry, caricamenti AJAX.

- Estrazione cloud e archiviazione dati.

- Piano gratuito e prova gratuita di 14 giorni per i piani Standard e Professional.

- Proxy residenziali a consumo; oltre 99 milioni di IP da 155 Paesi.

- Team di supporto altamente reattivo.

- Integrazione con app di terze parti tramite Octoparse RPA e accesso all’API.

Svantaggi:

- Guida insufficiente per gli scraper preconfigurati.

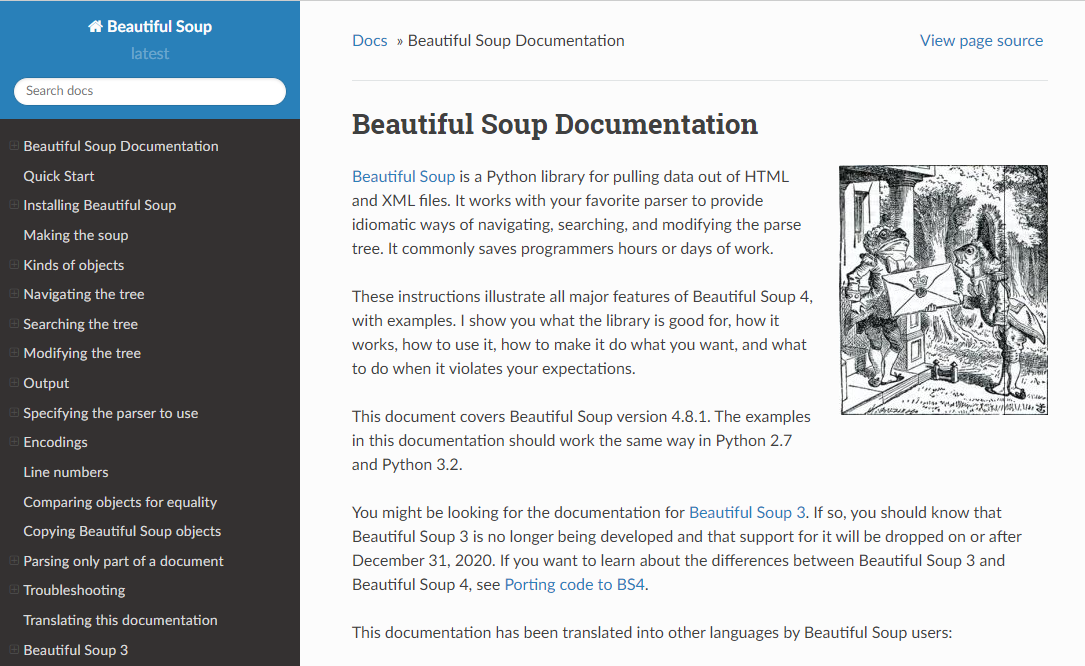

2. Beautiful Soup

A chi serve: sviluppatori che sono abili nel programmare per creare uno scraper web / web crawler per analizzare i siti web.

Cos’è: Beautiful Soup è una libreria Python open source progettata per lo web-scraping di file HTML e XML. Lo strumento è il top parser Python che è stato ampiamente utilizzato. Se hai competenze di programmazione, funziona meglio quando combini questa libreria con Python.

Vantaggi:

- Facile da usare: API intuitiva e sintassi semplice.

- Versatilità: gestisce documenti HTML e XML, anche se mal formattati o non validi.

- Flessibilità: consente di cercare e navigare l’albero di parsing usando nomi di tag, attributi e testo; inoltre, permette di modificare facilmente l’albero di parsing, rendendo possibile la pulizia e la ristrutturazione dei dati.

- Compatibilità con altre librerie: funziona bene con librerie Python come requests per il recupero delle pagine web e pandas per la manipolazione e l’analisi dei dati.

Svantaggi:

- Prestazioni più lente: nel caso di documenti di grandi dimensioni o task di scraping intensivi.

- Funzionalità integrate limitate: non include funzionalità per effettuare richieste HTTP; mancano opzioni avanzate come la gestione integrata di cookie, sessioni e meccanismi di retry.

- Curva di apprendimento più ripida: per task complessi.

3. Import.io

A chi serve: imprese con un budget alla ricerca di soluzioni di integrazione sui dati web.

Cos’è: Import.io è una piattaforma di dati web SaaS. Fornisce una soluzione di scraping web che ti permette di estrarre dati da siti web e organizzarli in set di dati. Essi possono integrare i dati web negli strumenti di analisi per le vendite e il marketing per ottenere intuizioni.

Vantaggi:

- Interfaccia intuitiva: piattaforma facile da usare, senza bisogno di programmazione.

- Scalabilità: in grado di gestire l’estrazione di grandi quantità di dati da numerosi siti web.

- Integrazione: offre API e servizi gestiti per un’integrazione fluida con altri strumenti e sistemi.

Svantaggi:

- Costoso: può essere oneroso, soprattutto per piccole imprese o utenti individuali.

- Curva di apprendimento lunga: necessaria per padroneggiare tutte le funzionalità e le caratteristiche.

- Limitazioni di personalizzazione.

4. Mozenda

A chi serve: aziende con esigenze di dati scalabili.

Cos’è: Mozenda fornisce uno strumento di estrazione dati che rende facile catturare contenuti dal web. Offrono anche servizi di visualizzazione dei dati. Elimina la necessità di assumere un analista di dati. E il team Mozenda offre servizi per personalizzare le opzioni di integrazione.

Vantaggi:

- Versatilità: consente l’estrazione di dati da diverse fonti, tra cui siti web, file PDF e documenti Word.

- Basato su cloud: offre la comodità dell’accesso remoto e la scalabilità, ideale per gestire progetti di scraping di grandi dimensioni.

- Team di supporto reattivo: l’assistenza è utile e pronta a rispondere.

- Eccellente gestione degli errori: efficiente nel rilevamento e nella risoluzione dei problemi.

- Potente e personalizzabile: in grado di gestire strutture di pagina complesse e set di dati voluminosi.

Svantaggi:

- Disponibile solo per Windows: Mozenda funziona esclusivamente su sistemi operativi Windows.

- Modello in abbonamento: richiede una sottoscrizione mensile, uno svantaggio per gli utenti che non necessitano di un utilizzo regolare.

- Curva di apprendimento: necessita di tempo per essere padroneggiato, risultando complesso per persone senza un background tecnico.

- Crediti di pagina: difficile stimare il numero esatto di crediti necessari per i progetti, il che può comportare costi imprevisti o l’acquisto di crediti aggiuntivi.

- Problemi di formattazione: l’intelligenza integrata a volte influisce sulla formattazione dei risultati, richiedendo ulteriori adattamenti per garantire l’accuratezza e l’usabilità dei dati.

5. Parsehub

A chi serve: analisti di dati, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: ParseHub è uno strumento di web scraping visibile per ottenere dati dal web. Puoi estrarre i dati facendo clic su qualsiasi campo sul sito web. Ha anche una funzione di rotazione IP che aiuta a cambiare il tuo indirizzo IP quando incontri siti web aggressivi con tecniche anti-scraping.

Vantaggi:

- Interfaccia intuitiva: consente di estrarre dati con semplici clic.

- Selezione flessibile dei dati: supporta metodi come XPath, selettori CSS e RegEx.

- Gestione di contenuti dinamici: ParseHub è efficace nello scraping di siti web complessi basati su JavaScript e AJAX.

- Esecuzione basata su cloud.

- Formati di esportazione: CSV, Excel e JSON.

Svantaggi:

- Prestazioni limitate: non ottimali per la gestione di grandi quantità di dati o progetti di scraping complessi.

- Supporto mobile limitato: non esiste un’app dedicata per dispositivi mobili.

6. Crawlmonster

A chi serve: SEO e marketer

Cos’è: CrawlMonster è uno strumento di web scraping gratis. Ti permette di analizzare siti web e analizzare i contenuti del tuo sito web, il codice sorgente, lo stato della pagina, ecc.

Vantaggi

- Analisi Completa: Offre strumenti analitici potenti per identificare e risolvere problemi tecnici sui siti web.

- Crawler personalizzabili: Gli utenti possono impostare programmi di scansione personalizzati, regolare la velocità del crawler e definire le stringhe dell’agente utente per allinearsi agli obiettivi del progetto.

- Supportati controlli di sicurezza.

Svantaggi

- Costo Potenziale: Il costo può aumentare a seconda delle funzionalità e delle dimensioni del progetto.

- Feedback Utente Limitato.

7. ProWebScraper

A chi serve: aziende che cercano soluzioni di integrazione sui dati web.

Cos’è: Connotate ha lavorato insieme a Import.io, il quale fornisce una soluzione per l’automazione dello scraping di dati web. Esso fornisce un servizio di dati web che ti aiuta a fare scraping, raccogliere e gestire i dati.

Vantaggi:

- Interfaccia facile da usare con funzionalità di punta e clic.

- Dispone di funzionalità come la paginazione, i generatori di URL, il supporto per XPath, CSS e regex.

- Supporta API.

Svantaggi:

- Versione gratuita limitata: La versione gratuita è limitata a 1000 query.

- Il piano base offre lo stoccaggio dei dati solo per 15 giorni, il che potrebbe essere limitante per gli utenti che necessitano di conservare i dati a lungo termine.

- Necessita di una connessione internet per funzionare.

8. Common Crawl

A chi serve: ricercatori, studenti e professori.

Cos’è: Common Crawl è fondato sull’idea di open source nell’era digitale. Fornisce dataset aperti di siti web analizzati. Contiene dati grezzi di pagine web, metadati estratti e estrazioni di testo.

Vantaggi:

- Gratuito e aperto a tutti;

- Dati estesi: Vanta un set di dati che copre oltre 250 miliardi di pagine web raccolte in 15 anni, con 3-5 miliardi di nuove pagine aggiunte mensilmente.

- I dati di Common Crawl sono stati citati in oltre 10.000 articoli di ricerca.

- Supporto della comunità, come Discord.

Svantaggi:

- Analisi dei dati complessa: Richiede competenze tecniche avanzate, in particolare nell’elaborazione e nell’analisi dei big data per gestire un pool di dati così vasto.

- Necessita di spazio di archiviazione e risorse computazionali adeguate per elaborare i dati.

- Granularità limitata: Sebbene i dati siano estesi, potrebbero non fornire sempre il livello di dettaglio necessario per casi d’uso specifici.

9. Crawly

A chi serve: persone con esigenze di dati base.

Cos’è: Crawly offre un servizio automatico di web scraping che esegue lo scraping di un sito web e trasforma i dati non strutturati in formati strutturati come JSON e CSV. Essi possono estrarre elementi limitati in pochi secondi, che includono il testo del titolo, l’HTML, i commenti, DateEntity Tags, Author, URL delle immagini, Video, Publisher e Paese.

Vantaggi:

- Facile da usare: Inserisci un URL e puoi ottenere tutti i dati strutturati da una pagina.

Svantaggi:

- Controllo limitato: Sebbene semplifichi il processo di scraping, potrebbe offrire meno controllo rispetto agli scraper personalizzati progettati per esigenze specifiche.

- Necessita di connessione a Internet per eseguire le attività di scraping.

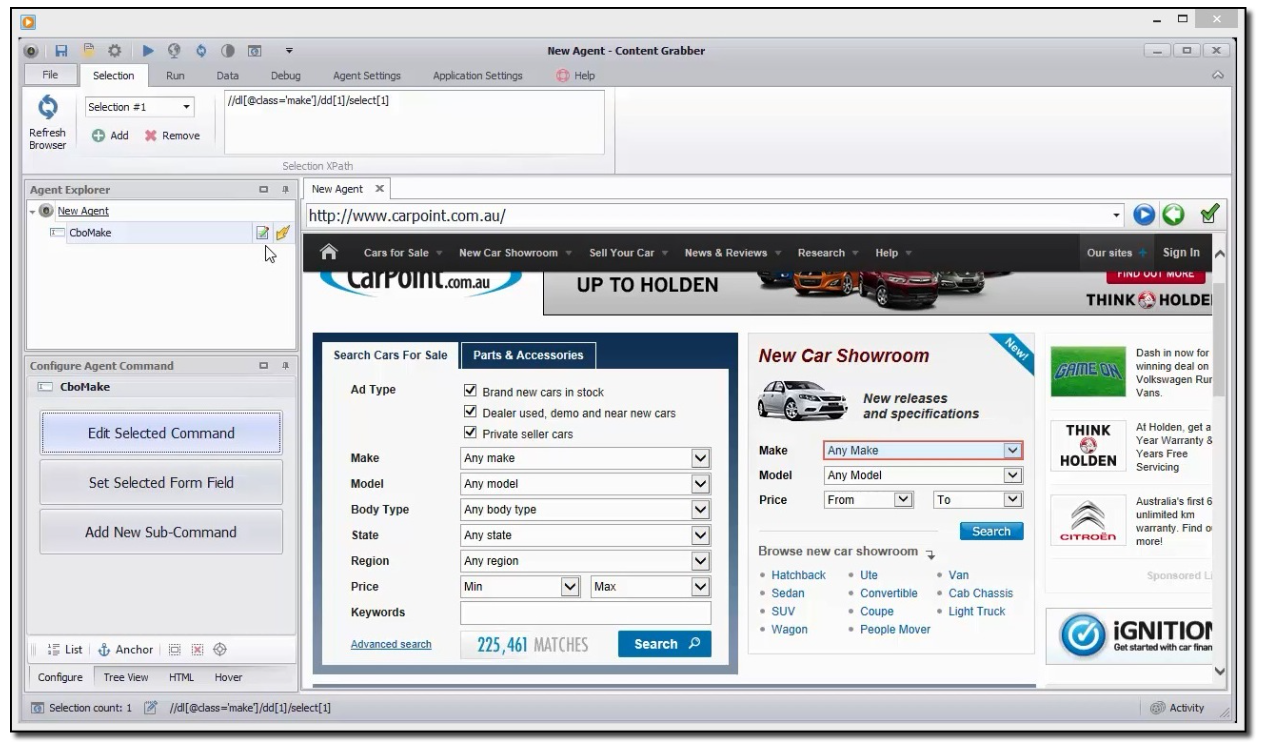

10. Content Grabber

A chi serve: sviluppatori Python che sono bravi a programmare.

Cos’è: Content Grabber è uno strumento di web scraping rivolto alle imprese. Puoi creare i tuoi agenti di scraping web con i suoi strumenti di terze parti integrati. È molto flessibile nel gestire siti web complessi e nell’estrazione dei dati.

Vantaggi:

- Ha un’interfaccia facile da usare, con funzionalità di click-e-punta.

- Funzionalità avanzate: Include strumenti avanzati per il debug, la registrazione, la gestione degli errori e la possibilità di scrivere script personalizzati.

- I dati possono essere esportati in vari formati come CSV, Excel, XML e database.

- Gestione di siti complessi: È in grado di fare scraping su siti con JavaScript e AJAX.

Svantaggi:

- Abbastanza costoso: Il prezzo di partenza per una licenza enterprise è di circa 5.500 dollari all’anno.

- Supporto clienti limitato.

- Sembra che non venga aggiornato da molto tempo.

11. Diffbot

A chi serve: sviluppatori e aziende.

Cos’è: Diffbot è uno strumento di web scraping che utilizza l’apprendimento automatico e gli algoritmi pubblici e le API per estrarre dati dalle pagine web. Diffbot ti aiuta a fare analisi dei concorrenti, monitorare i prezzi, analizzare i comportamenti dei consumatori e molto altro ancora.

Vantaggi:

- Può essere integrato in diverse applicazioni.

- È in grado di gestire compiti di estrazione dati web su larga scala.

- Si aggiorna continuamente nel Knowledge Graph.

- Permette di risparmiare tempo ed energie nella creazione e gestione di sistemi di scraping da zero.

Svantaggi:

- Abbastanza costoso: a partire da 299 dollari al mese.

- Personalizzazione limitata.

- Instabilità occasionale.

- Il supporto clienti a volte può richiedere del tempo per rispondere.

12. Dexi.io

A chi serve: persone con competenze di programmazione e scraping.

Cos’è: Dexi.io è un web crawler basato su browser. Fornisce tre tipi di robot — Extractors, crawlers e Pipes. PIPES ha una funzione Master robot dove 1 robot può controllare molteplici attività. Supporta molti servizi di terze parti (solutori di captcha, storage cloud, ecc) che puoi facilmente integrare nei tuoi robot.

Vantaggi:

- Ha un editor visivo che è facile da usare anche per chi non è programmatore.

- Può essere integrato con più strumenti e servizi di terze parti.

- È in grado di simulare il comportamento umano di navigazione, gestire i CAPTCHA, eseguire lo scrolling infinito ed eseguire JavaScript per compiti di scraping più sofisticati.

Svantaggi:

- Complicato per i principianti.

- Potrebbe non replicare tutte le funzionalità dei browser comuni come Chrome.

- Tempi di risposta lenti e difficoltà nel ottenere rimborsi.

13. Hexomatic

A chi serve: Chiunque non sappia di programmazione.

Cos’è: Hexomatic è uno strumento versatile di scraping web e automazione senza codice, progettato per consentire agli utenti di raccogliere dati dai siti web senza necessitare di competenze tecniche. Offre una vasta gamma di funzionalità, tra cui ricette di scraping, flussi di lavoro e automazione.

Vantaggi:

- Utile per chi non ha competenze tecniche.

- Offre oltre 100 strumenti di automazione diversi, che possono aiutare a semplificare compiti come l’estrazione dei dati, l’analisi del sentiment e la generazione di contenuti.

Svantaggi:

- Sono segnalati problemi di performance quando si eseguono operazioni di scraping su siti protetti.

- Il supporto clienti è talvolta poco reattivo.

14. Easy Web Extract

A chi serve: imprese con esigenze di dati limitate, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: Easy Web Extract è uno strumento visuale di web scraping per scopi di business. Può estrarre il contenuto (testo, URL, immagine, file) dalle pagine web e trasformare i risultati in vari formati.

Vantaggi:

- Facile da usare per chi non ha competenze di programmazione.

- Tassa di acquisto una tantum di $59,99.

- È disponibile una versione di prova gratuita e una versione gratuita.

- Efficace nello scraping di contenuti e immagini.

Svantaggi:

- La configurazione iniziale può risultare difficile per gli utenti senza background tecnico.

- Nessuna opzione di integrazione.

- Supporto clienti scarso.

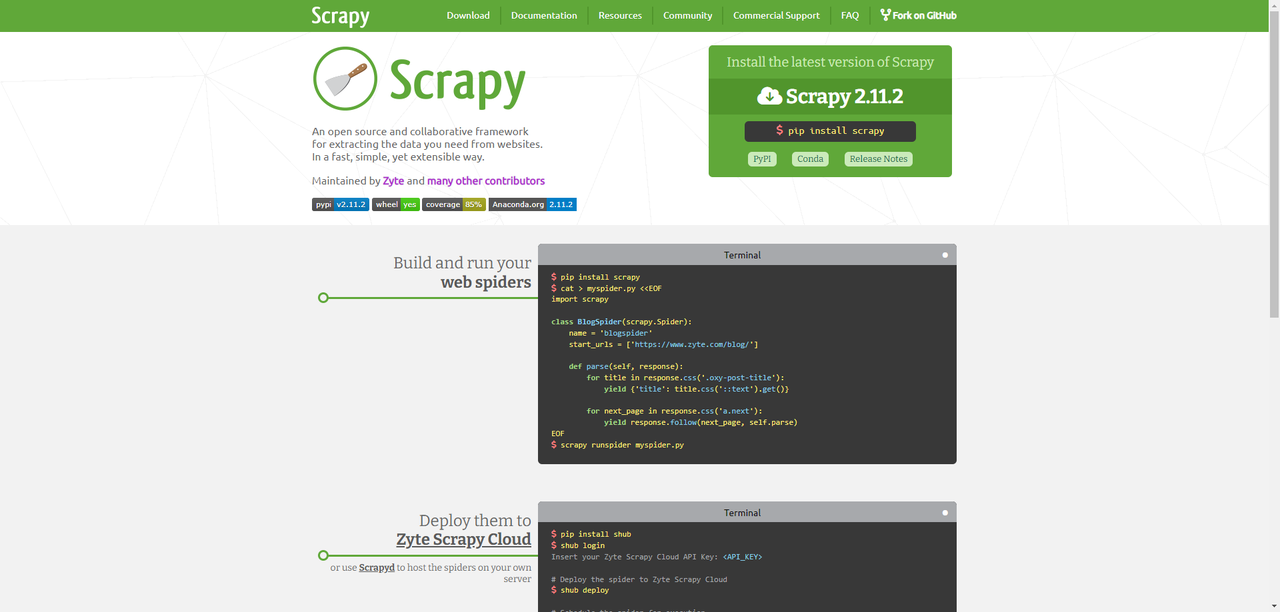

15. Scrapy

A chi serve: sviluppatori Python con competenze di programmazione e scraping.

Cos’è: Scrapy può essere utilizzato per costruire un web scraper. Ciò che è eccezionale circa questo prodotto è che ha una libreria di rete asincrona che ti permete di passare al compito successivo prima che finisca.

Vantaggi:

- Molto flessibile: consente agli utenti di personalizzare il processo di scraping. Supporta vari middleware e componenti della pipeline per elaborare i dati estratti.

- Networking asincrono: può gestire richieste multiple contemporaneamente.

- Documentazione completa.

- Forte comunità: i nuovi utenti possono trovare soluzioni ai loro problemi.

- Gestisce compiti di scraping complessi, inclusi siti web con AJAX e JavaScript intensivi.

Svantaggi:

- Difficile per chi non conosce Python.

- Configurazione ed impostazione complesse anche per un compito semplice. Altri strumenti più semplici potrebbero essere più adatti.

- Richiede una notevole potenza di calcolo e memoria per progetti su larga scala.

- Richiede manutenzione continua.

16. Helium Scraper

A chi serve: analisti di dati, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: Helium Scraper è uno strumento visuale di web scraping che funziona molto bene, specialmente su piccoli elementi sul sito web. Ha un’interfaccia user-friendly di punto-e-clic che lo rende più facile da usare.

Vantaggi:

- Offre un’interfaccia punto-e-clicca.

- Supporta formati di esportazione come CSV, Excel, JSON e SQLite.

- Gli utenti possono automatizzare i compiti di estrazione dei dati, configurare crawler e pianificare attività di scraping.

- Supporto per espressioni regolari.

Svantaggi:

- Principalmente progettato per Windows.

- Potrebbe essere necessaria una maggiore competenza tecnica quando si utilizzano JavaScript personalizzati per scenari complessi.

- Supporto clienti limitato.

- Il costo iniziale (acquisto una tantum) potrebbe essere più elevato rispetto alle alternative basate su abbonamento.

17. Grepsr

A chi serve: persone che necessitano di dati scalabili senza codifica.

Cos’è: Grepsr offre soluzioni dati end-to-end, dalla consulenza iniziale alla raccolta e manutenzione dei dati.

Vantaggi:

- Gratuito per la configurazione dello scraper, l’estrazione dei dati e la manutenzione dei processi.

- Alta precisione dei dati.

- Scalabile e adattato a vari settori come e-commerce, immobiliare e marketing.

- Servizio clienti rapido e personalizzato.

Svantaggi:

- Il servizio premium potrebbe essere costoso per le piccole imprese, con prezzi a partire da $350.

- Alta dipendenza da Grepsr, il che potrebbe comportare rischi potenziali.

18. Pline.io

A chi serve: un ambiente di analisi dei dati Python e R. Ideale per economisti, statistici e gestori di dati che sono nuovi alla programmazione.

Cos’è: Pline.io è uno strumento di web scraping che offre una soluzione di estrazione dati facile e intuitiva tramite un’estensione del browser.

Vantaggi:

- Installazione e utilizzo facili senza necessità di codice.

- Supporta sia l’estrazione manuale che automatica dei dati.

- Offre estrazione dati illimitata per un periodo di tempo limitato.

- Adatto per vari casi d’uso come monitoraggio dei prezzi dinamici, analisi di mercato e analisi del sentiment.

- Piano gratuito disponibile.

Svantaggi:

- Supporta solo i browser basati su Chromium.

- Limitata conservazione dei dati.

- Nessun accesso API per il momento.

- Nessuna pianificazione delle attività e nessuna estrazione cloud.

- Problemi di scalabilità per un’estensione.

19. Zyte

A chi serve: sviluppatori Python/web scraping

Cos’è: Zyte, conosciuto anche come Scraping Hub, è una piattaforma web basata sul cloud. Possiede quattro diversi tipi di strumenti — Scrapy Cloud, Portia, Crawlera e Splash. È una cosa fantastica che Zyte offra una raccolta di indirizzi IP che coprono più di 50 paesi, per cui costruisce una soluzione per i problemi di blocco IP.

Vantaggi:

- Offre molti strumenti e servizi, inclusi Scrapy.

- Gestisce esigenze di estrazione dati su larga scala.

- Supporto della comunità.

- Può essere integrato con vari altri strumenti e piattaforme.

Svantaggi:

- Costoso, in particolare per progetti su larga scala o utilizzo a livello aziendale.

- Curva di apprendimento ripida per i principianti.

20. Screen-Scraper

A chi serve: aziende correlate alle industrie dell’automobile, medicale, finanziaria e dell’e-commerce.

Cos’è: Screen-scraper offre un servizio di web scraping per aziende in molti settori, come quello medico, finanziario, automobilistico, e-commerce e immobiliare. Simulando il comportamento umano nel visitare i siti web, Screen-scraper raccoglie le informazioni automatizzando azioni come copiare testi, cliccare su link, inserire dati nei moduli, navigare tra i risultati di ricerca e scaricare vari tipi di file. Può anche gestire AJAX e integrarsi con un’ampia gamma di linguaggi di programmazione e sistemi operativi.

Vantaggi:

- Screen-scraper è stato sviluppato e perfezionato nel corso di molti anni.

- Può essere eseguito su più sistemi operativi, inclusi Windows, Linux e macOS.

- Si integra facilmente con i sistemi tramite API o connessioni dirette al database, supportando linguaggi come .NET, Java, Ruby e Python.

Svantaggi:

- Ambiguità del prezzo.

21. ScrapeHero

A chi serve: investitori, Hedge Fund, analisti di mercato

Cos’è: ScrapeHero, come azienda di dati, costruisce API personalizzate in tempo reale per siti web che non offrono un’API o che hanno un’API con limiti di frequenza. Fornisce anche un servizio di web scraping che offre dati in un’unica soluzione, insieme all’analisi dei dati.

Vantaggi:

- Utilizzano AI e ML per i controlli di qualità dei dati.

- Supportano vari formati di dati (JSON, CSV, XML, ecc.) e possono integrarsi con soluzioni di archiviazione cloud come AWS, Google Cloud e Azure.

Svantaggi:

- Più costoso rispetto agli strumenti di web scraping più semplici e fai-da-te.

22. Web Content Extractor

A chi serve: analisti di dati, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: Web Content Extractor è uno strumento di web scraping facile da utilizzare per individui e imprese. Puoi andare sul loro sito web e provare la sua prova gratuita di 14 giorni.

Vantaggi:

- Non richiede conoscenze di programmazione.

- Consente agli utenti di programmare lo scraping in base alle loro esigenze.

- Offre più formati per l’esportazione dei dati, come CSV, Excel, XML e database.

Svantaggi:

- Pagamento una tantum. Potrebbe essere costoso per utenti con compiti di piccole dimensioni.

- Nessun accesso API.

- Sono disponibili poche tecniche di anti-blocco.

23. WebHarvy

A chi serve: analisti di dati, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: WebHarvy è uno strumento di scraping web con interfaccia punto-e-clicca, progettato per utenti non programmatori. Offrono utili tutorial di web scraping per principianti.

Vantaggi:

- Interfaccia punto-e-clicca facile da usare.

- Supporta lo scraping di diversi tipi di dati, tra cui testo, immagini e dati strutturati complessi.

- Gli utenti possono automatizzare compiti come cliccare link, selezionare opzioni da menu a tendina e inserire testo.

- Supporta JavaScript, l’uso di server proxy e le espressioni regolari per uno scraping più personalizzato.

Svantaggi:

- Prestazioni lente nelle estrazioni di grandi quantità di dati.

- L’estrattore non consente di programmare i progetti di scraping.

- Disponibile solo per Windows.

- Nessuna risoluzione CAPTCHA integrata né tecniche di anti-blocco.

- Offre una licenza lifetime senza costi mensili ricorrenti, che può essere più economica nel lungo periodo.

24. Web Scraper.io – Estensione Chrome

A chi serve: analisti di dati, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: Web Scraper.io è un’estensione di Chrome utilizzata per estrarre dati da siti web e salvarli in vari formati come CSV, JSON e XLSX. Per chi non ha conoscenze di programmazione, offre un’interfaccia user-friendly con un sistema di selezione modulare per un’estrazione dei dati precisa. Fornisce anche opzioni di integrazione con piattaforme come Dropbox, Google Sheets e Amazon S3 tramite l’API e l’accesso webhook.

Vantaggi:

- Interfaccia punto-e-clicca.

- I dati possono essere esportati in vari formati (CSV, JSON, XLSX) e sono supportate integrazioni con piattaforme popolari come Dropbox e Google Sheets.

- Gli utenti possono automatizzare l’estrazione dei dati su base oraria, giornaliera o settimanale.

- Uso locale gratuito e illimitato.

Svantaggi:

- Scarse prestazioni: lento, incline a crash e difficoltà nell’affrontare compiti di estrazione di grandi dimensioni.

- La versione gratuita ha limitazioni significative (può estrarre solo alcune pagine).

- Supporto limitato: si basa principalmente sul supporto della community per risolvere i problemi.

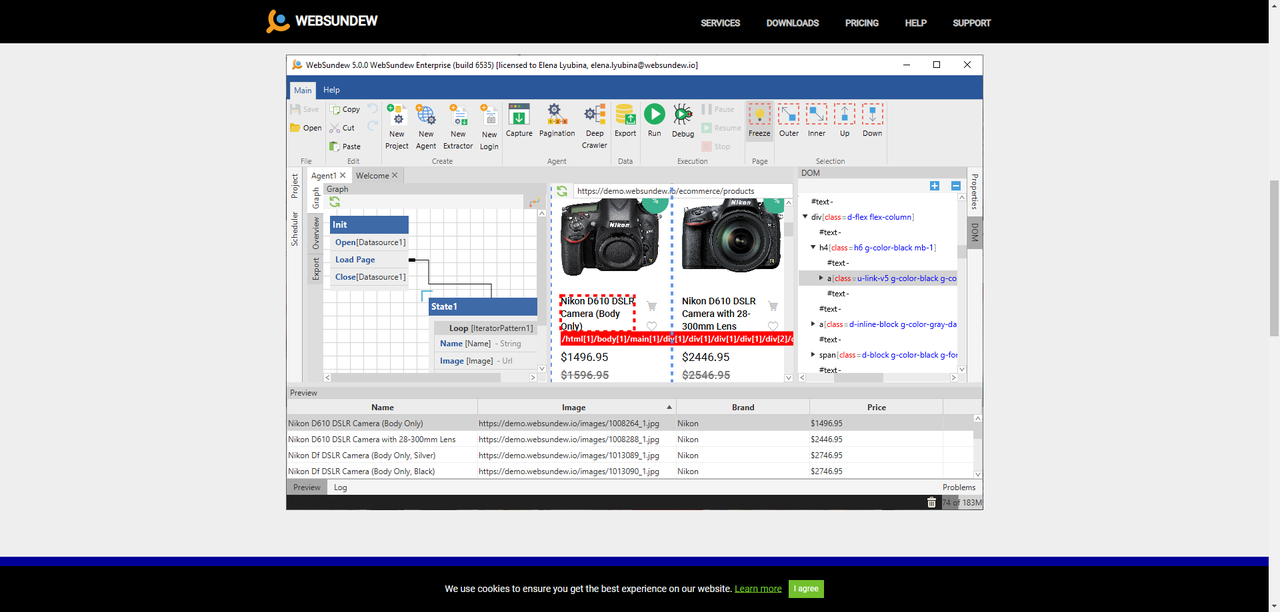

25. Web Sundew

A chi serve: imprese, marketer e ricercatori.

Cos’è: WebSundew è uno strumento di scraping visuale che funziona per lo scraping di dati web strutturati. L’edizione Enterprise ti permette di eseguire i progetti di scraping su un server remoto e pubblicare i dati raccolti tramite FTP.

Vantaggi:

- Ha un’interfaccia user-friendly.

- Può estrarre testo, file, immagini e PDF.

- Include funzionalità come estrazione incrementale, integrazione API e riconoscimento del testo.

- Disponibile in versione desktop e cloud, supporta Windows, Mac e Linux.

Svantaggi:

- È costoso, con il piano base che costa 99$ offrendo poche funzionalità.

- Prestazioni lente quando si trattano set di dati estremamente grandi o siti web molto complessi.

26. Web Robots

A chi serve: analisti di dati, marketer e ricercatori che non hanno competenze di programmazione.

Cos’è: Web Robots è una piattaforma di web scraping basata sul cloud per lo scraping di siti web dinamici pesanti di Javascript. È fornito di un’estensione del browser web così come un software desktop, il che rende facile il data scraping dai siti web.

Vantaggi:

- Offre sia soluzioni senza codice che con codice.

- È disponibile una documentazione estesa e tutorial.

- Può eseguire scraping di siti web dinamici basati su JavaScript e estrarre dati da fonti deep-web che richiedono login e compilazione di moduli.

Svantaggi:

- Le funzionalità più avanzate e la scrittura di robot personalizzati potrebbero essere difficili per i principianti.

- Il servizio completo è abbastanza costoso rispetto a una soluzione fai-da-te.

- Alcune funzionalità dipendono fortemente da Chrome, il che potrebbe limitare la compatibilità con altri browser o ambienti.

27. Selenium – Libreria Python

A chi serve: web scrapers, tester di controllo qualità, sviluppatori web, ricercatori, ecc., che hanno conoscenze di programmazione.

Cos’è: Selenium è un potente framework di web scraping e di automazione dei test che ti permette di interagire con i browser web, eseguire scraping di contenuti dinamici, automatizzare attività ripetitive, testare applicazioni web e raccogliere dati dai siti web. Ci offre flessibilità, supporto complessivo linguistico e assitenza della comunità ampia.

Vantaggi:

- Supporta tutti i principali browser (Chrome, Firefox, Safari, Internet Explorer, Edge) e può funzionare su più piattaforme (Windows, Mac, Linux).

- Supporta diversi linguaggi di programmazione, tra cui Java, C#, Python, Ruby e JavaScript.

- Si integra bene con altri strumenti e framework, come TestNG, JUnit, Maven, Jenkins e Docker.

- Fornisce un controllo dettagliato sugli elementi web e le azioni dell’utente, rendendolo adatto a scenari di test complessi e compiti di automazione sofisticati.

Svantaggi:

- Può essere complesso e difficile da imparare per i principianti.

- Richiede un notevole impegno di manutenzione nelle attività automatizzate per tenere il passo con i cambiamenti nell’interfaccia utente e nella funzionalità dell’applicazione web.

- Mancanza di report di test integrati.

- Ogni browser richiede un driver specifico (ad esempio, ChromeDriver per Chrome), il che aggiunge un ulteriore livello di complessità e potenziali problemi di compatibilità.

28. Puppeteer – Libreria Node.js

A chi serve: sviluppatori web, appassionati di automazione, analisti di dati e chi ha conoscenze di programmazione.

Cos’è: Puppeteer è una libreria Node.js sviluppata da Google. Offre una API di alto livello per controllare i browser headless Chrome o Chromium, che consente agli utenti di automatizzare le interazioni web, fare scraping di contenuti dinamici, condurre test sui browser, generare screenshot o PDF, e molto altro.

Leggi l’articolo sui linguaggi di programmazione più pagati più conoscenze in codifica.

Vantaggi:

- Opera in modalità headless per impostazione predefinita, rendendolo più veloce ed efficiente per le attività automatizzate, poiché non è necessario rendere l’interfaccia grafica.

- Eccellente nella gestione di siti web ricchi di JavaScript, applicazioni a pagina singola (SPA) e contenuti dinamici.

- Offre una API semplice e intuitiva.

- Può anche funzionare in modalità “headful” con interfaccia grafica, utile per il debugging e lo sviluppo.

Svantaggi:

- Progettato specificamente per Node.js, il che potrebbe non essere adatto agli sviluppatori che utilizzano altri linguaggi di programmazione.

- Eseguire un browser completo (anche in modalità headless) può essere più impegnativo in termini di risorse rispetto ad altri strumenti di scraping che non rendono le pagine web.

- Supporta principalmente Chrome e Chromium.

- Può consumare molta memoria, specialmente quando si affrontano attività di scraping complesse o su larga scala.

29. Apify

A chi serve: Persone che conoscono la programmazione e hanno bisogno di fare web scraping.

Cos’è: Apify è una piattaforma robusta di web scraping e automazione che fornisce una suite completa di strumenti per estrarre e processare dati web. Tra tutte le funzionalità, hanno un “Actor store” dove gli sviluppatori possono trovare centinaia di scraper già pronti, con istruzioni chiare e dettagliate su come configurarli.

Vantaggi:

- Gestisce siti web complessi con AJAX e JavaScript.

- Supporta integrazioni.

- Una comunità di utenti forte e una documentazione estesa.

Svantaggi:

- Difficile per gli utenti senza competenze tecniche.

- Ambiguità nel prezzo.

30. Oxylabs.io

A chi serve: Chiunque abbia bisogno di un servizio proxy per i propri progetti di web scraping.

Cos’è: Oxylabs è una delle aziende leader che fornisce proxy residenziali e di data center. Per chi non vuole scrivere script, offrono anche API per lo scraping e servizi di raccolta dati.

Vantaggi:

- Proxy con alti tassi di successo.

- Facile da scalare per i progetti di scraping. Adatto per le aziende che richiedono una grande quantità di dati.

- Supporta il rendering JavaScript e la rotazione degli IP.

Svantaggi:

- Può essere costoso per le piccole aziende e per gli individui.

- Complesso da usare per chi non ha competenze tecniche.

Pensieri finali

Estrarre dati dai siti web con gli strumenti di web scraping è un metodo che fa risparmiare tempo, soprattutto per coloro che non hanno una conoscenza di codifica sufficiente. Ci sono molti fattori che dovresti considerare quando scegli un tool adeguato per facilitare il tuo web scraping, come la facilità d’uso, l’integrazione dell’API, l’estrazione basata su cloud, lo scraping su larga scala, la programmazione di progetti, ecc. Il software di web scraping come Octoparse non solo fornisce tutte le funzionalità che ho appena menzionato, ma fornisce anche servizi di dati per team di tutte le dimensioni – dalle start-up alle grandi imprese.