A volte è necessario scaricare contenuto web da un sito per la visualizzazione offline o per un riferimento futuro. In altri casi, potrebbe essere necessario addirittura la copia dell’intero sito come backup. In questi casi, potrebbe essere necessario un website ripper per scaricare parzialmente o completamente il sito sul tuo spazio di archiviazione locale per l’accesso offline. In questo articolo, presenteremo 4 semplici website ripper disponibili su internet.

Cos’è un website copier

È facile ottenere contenuti aggiornati da un sito in tempo reale con un feed RSS. Tuttavia, esiste un altro metodo che ti aiuta ad avere i tuoi contenuti preferiti più rapidamente a disposizione. Un website downloader ti consente di scaricare l’intero sito e salvarlo sul tuo hard disk per navigare senza alcuna connessione internet. Ci sono tre strutture essenziali – sequenze, gerarchie e web, che vengono utilizzate per costruire un sito web. Queste strutture decidono come vengono visualizzate e organizzate le informazioni. Ecco la lista dei 4 migliori software di website ripper nel 2026. La lista è basata sulla facilità d’uso, popolarità e funzionalità.

I 4 migliori website ripper facili da usare

1. Octoparse

Octoparse è uno dei migliori strumenti di download di siti web disponibili oggi, progettato per rendere semplice e veloce il processo di estrazione di contenuti da qualsiasi pagina web. Può aiutarti a estrarre dati in tempo reale, permettendoti di ottenere informazioni sempre aggiornate per monitorare i cambiamenti dei tuoi competitor. Octoparse offre una modalità di scraping basata su cloud, che ti consente di programmare le estrazioni in qualsiasi momento.

Per rendere lo scraping dei dati ancora più semplice, Octoparse mette a disposizione una funzione di rilevamento automatico basata sull’AI, in grado di riconoscere i campi dati e creare automaticamente un crawler. Sono inoltre disponibili funzionalità avanzate come il bypass dei CAPTCHA, l’uso di proxy, la rotazione degli IP, XPath e molto altro.

In più, Octoparse offre modelli di scraping pre-impostati per i siti web più popolari, che ti permettono di raccogliere dati in pochi clic. Non è necessario scaricare nulla: basta visualizzare l’anteprima del campione di dati e inserire alcuni parametri. Clicca sul link qui sotto per iniziare una prova gratuita.

https://www.octoparse.it/template/html-scraper

2. HTTrack

HTTrack è un software gratuito molto semplice ma potente per raschiare siti web. È capace di scaricare l’intero sito web da Internet sul tuo PC. Inizia con Wizard e segui le impostazioni. Puoi decidere contemporaneamente il numero di connessioni durante il download delle pagine web sotto “set option”. Si può ottenere le foto, i file e il codice HTML dalle intere directory, aggiornare il sito web speculato attuale e riprendere i download interrotti.

Lo svantaggio è che non può essere utilizzato per scaricare una singola pagina del sito web. Invece, scaricherà l’intera radice del sito web. Inoltre, impiega un po’ di tempo per escludere manualmente i tipi di file se desideri solo scaricarne di particolari.

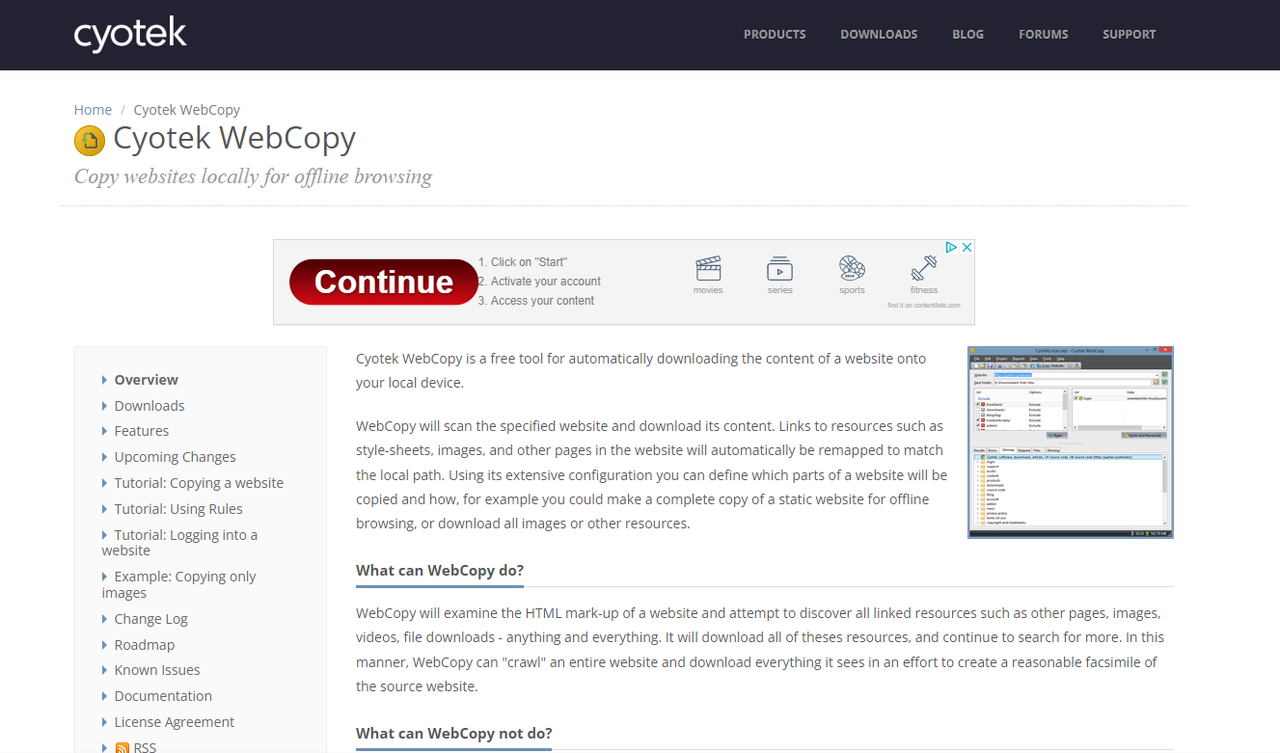

3. Cyotek WebCopy

WebCopy è un copiatore di siti web che ti permette di copiare parzialmente o completamente i siti web localmente per la lettura offline. Esaminerà la struttura dei siti web e le risorse collegate, tra cui i fogli di stile, le immagini, i video e altro. E queste risorse collegate verranno automaticamente mappate per corrispondere al loro percorso locale.

Lo svantaggio è che Cyotek WebCopy non può analizzare/fare il crawling/eseguire lo scraping ai siti web che applicano Javascript o qualsiasi funzione dinamica. Non può estrapolare il codice sorgente grezzo del sito web ma solo quello che visualizza sul browser.

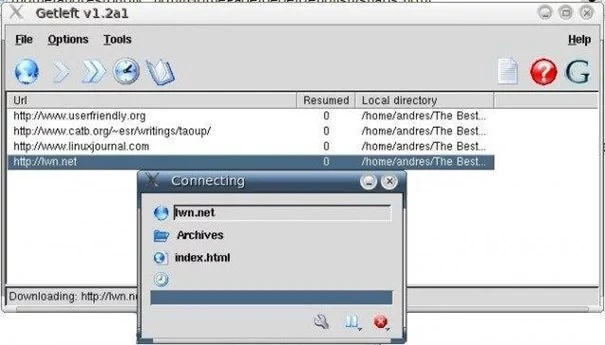

4. Getleft

Getleft è un catturatore di siti web gratuito e facile da utilizzare che può essere utilizzato per strappare un sito web. Scarica un intero sito web con la sua interfaccia facile da usare e le molteplici opzioni. Dopo aver lanciato Getleft, puoi inserire un URL e scegliere i file che dovrebbero essere scaricati prima di iniziare a scaricare il sito web.

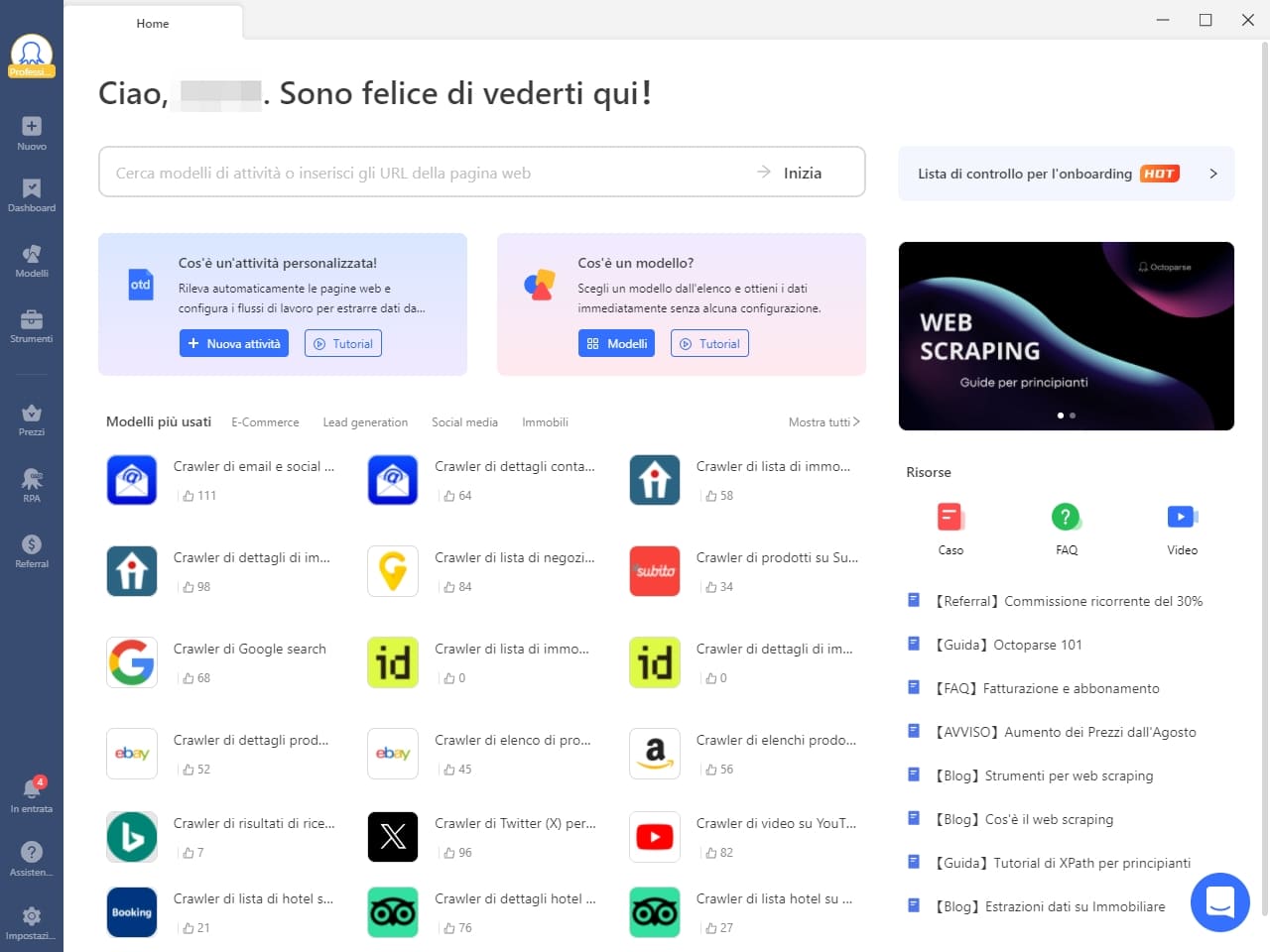

Come scaricare siti web con Octoparse

In questi giorni, è facile creare scraper con una varietà di strumenti per lo scaricamento di siti web. Octoparse, il migliore strumento di web scraping, è una soluzione senza codice che consente a chiunque di estrarre l’intero sito senza avere competenze di programmazione.

Passaggi semplici per scaricare siti web con Octoparse

Scarica Octoparse gratuitamente se non hai il software sul tuo dispositivo. Per sbloccare le potenti funzionalità di Octoparse, devi creare un nuovo account o accedere con il tuo account esistente di Google o Microsoft. Seguire la guida qui sotto per configurare lo scraper per scaricare siti web in pochi minuti.

Passaggio 1: Creare una nuova attività per lo scaricamento di sito web

Copiare e incollare l’URL della pagina web di destinazione nella barra di ricerca dell’applicazione Octoparse. Fare clic su Inizia per cominciare la costruzione del task.

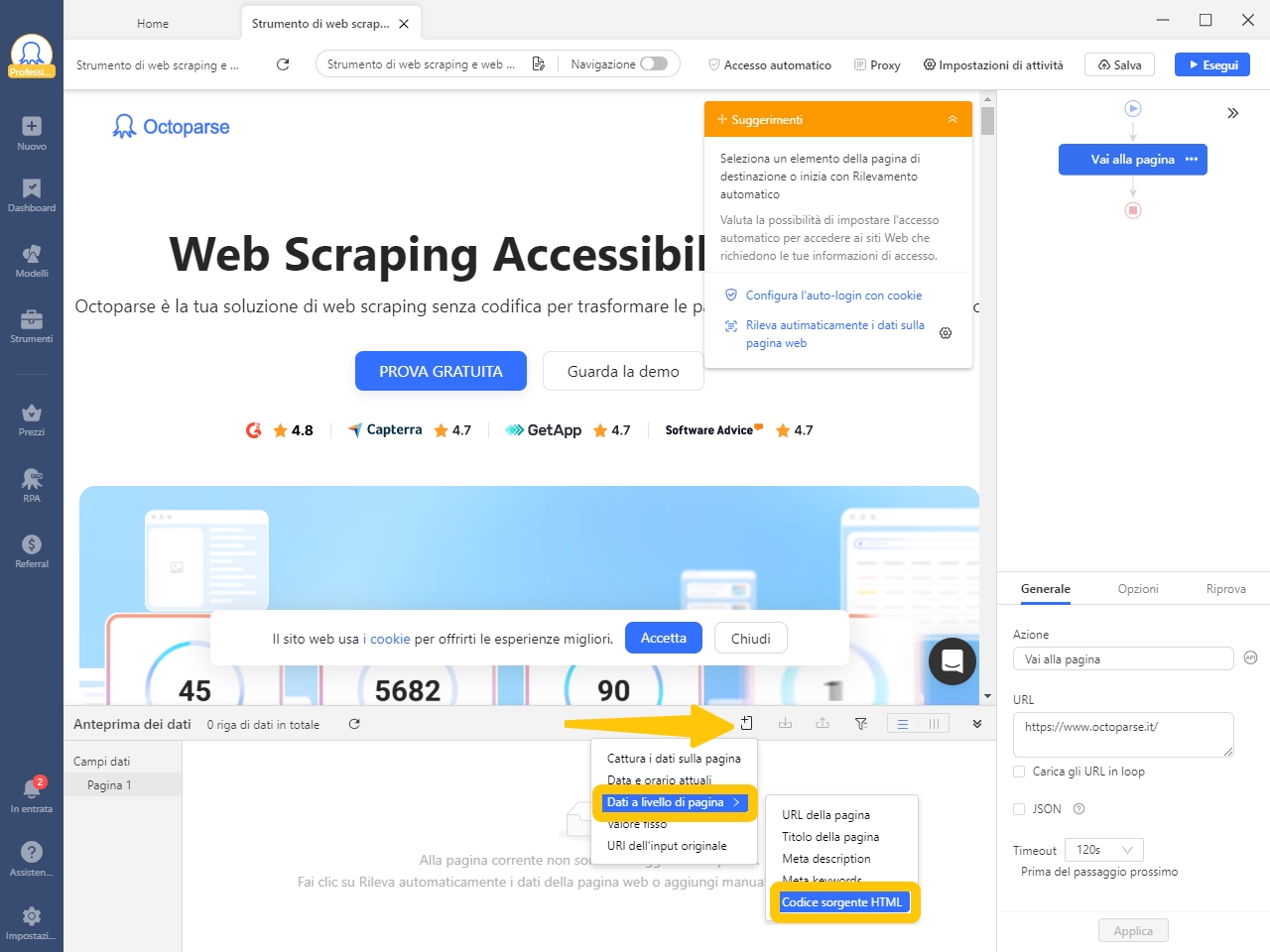

Passaggio 2: Scaricare il codice HTML

Dopo il caricamento della pagina web nel browser integrato, fare clic su Aggiungi campo personalizzato. Nel menù di dati a livello di pagina puoi trovare Codice sorgente HTML. Selezionalo e il software ti estrae l’intero codice HTML del sito.

Passaggio 3: Eseguire l’attività per ottenere i dati

Salva l’attività e inizia lo scraping cliccando sul bottone Esegui. I dati estratti possono essere scaricati in formati come Excel, csv, ecc. o direttamente nel tuo database.

Conclusione

I website downloader sono strumenti essenziali per chi ha bisogno di salvare e accedere a siti web offline o come backup. Con diverse opzioni disponibili, ognuna con caratteristiche uniche, è possibile scegliere il software più adatto in base alle proprie esigenze. Octoparse si distingue per la sua facilità d’uso e per la possibilità di scaricare interi siti web senza necessitare di codifica. Altri strumenti come HTTrack, Cyotek WebCopy e Getleft offrono soluzioni pratiche per scaricare siti web, ma la scelta finale dipende dalla complessità del sito e dalle specifiche funzionalità richieste. Scegli il tool giusto per ottimizzare il tuo lavoro!

FAQ – Domande frequenti per website downloader e web scraping 2026

1. Qual è la differenza tra un website copier e un web scraper come Octoparse?

Un website copier (come HTTrack) scarica i file statici (HTML, CSS, Immagini) per visualizzare il sito offline. Uno strumento di web scraping come Octoparse, invece, oltre a scaricare l’intero sito, estrae dati strutturati (prezzi, descrizioni, contatti) da pagine dinamiche e li organizza in file Excel, CSV o database.

2. Posso usare Octoparse per copiare dati da siti web dinamici?

Certamente. A differenza dei copier tradizionali che faticano con i contenuti moderni, Octoparse simula il comportamento umano, gestisce lo scrolling infinito e i clic sui pulsanti, permettendoti di acquisire dati anche da siti complessi.

3. È legale copiare o scaricare dati da altri siti web?

L’estrazione di dati pubblici è generalmente legale per uso analitico, a patto di rispettare il GDPR e i termini di servizio del sito. Si consiglia sempre di non sovraccaricare i server di destinazione e di impostare una velocità di scansione ragionevole.

4. Come posso automatizzare il monitoraggio dei siti scaricati?

Con il servizio cloud di Octoparse, puoi programmare le attività di estrazione affinché venga eseguito ogni ora, giorno o settimana, ricevendo dati aggiornati automaticamente senza dover riavviare il processo manualmente.

Trasforma i dati del sito web in Excel, CSV, Fogli Google o direttamente nel database.

Estrazione di dati facile con rilevamento automatico senza programmazione.

Modelli di scraping pre-costruiti per siti web più popolari per ottenere dati in pochi clic.

Non essere mai bloccato con proxy IP e API avanzato.

Servizio cloud per programmare il data scraping in qualsiasi momento tu voglia.