Ebbene, ti sei mai chiesto come i motori di ricerca popolari come Google, Yahoo e Bing possano cercare tra milioni di pagine web e fornirti gli articoli più rilevanti alla tua ricerca in una cosa di millisecondi?

Lo fanno utilizzando un bot, chiamato web crawler. Esso naviga su Internet, raccoglie link rilevanti e li memorizza. Questo è particolarmente utile nei motori di ricerca e anche nello scraping web. È possibile creare questo web scraper da soli. Tutto ciò di cui hai bisogno è conoscere alcuni prerequisiti di base del linguaggio di programmazione Python.

Se stai cercando alternative che non richiedono la codifica, non preoccuparti, siamo qui per te. Questo articolo mira ad esplorare sia i metodi di codifica che quelli non di codifica per creare un web scraper.

Alternativa a Python: Creare un web scraper senza codifica

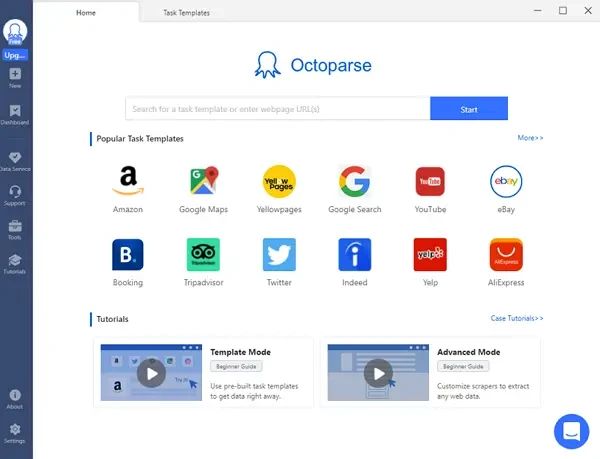

Puoi costruire un crawler utilizzando Scrapy di python, anche se richiede una certa conoscenza della codifica. Ma esistono alternative a Python per creare web crawler? Certamente sono disponibili strumenti e software per creare il tuo crawler per lo scraping web, tra cui quello migliore finora è Octoparse.

Octoparse è uno strumento di web scraping facile da usare. È uno degli strumenti più utilizzati per estrarre dati in blocco da più siti web. Supporta fino a 10.000 link in una sola volta. Alcune delle caratteristiche più interessanti di Octoparse sono elencate di seguito:

- È facile da usare anche se non si ha nessuna conoscenza su programmazione.

- Funzione di rilevamento automatico per aiutarti a costruire il crawler molto più facile.

- Esporta i dati estratti in vari formati di file e database.

- Modelli pre-costruiti per i siti web più popolari per estrarre dati con pochi clic.

- Le attività di scraping possono essere pianificati in qualsiasi momento – ogni ora, ogni giorno o ogni settimana.

- Il meccanismo di rotazione degli IP impedisce che il tuo IP venga bloccato.

Come creare un web crawler con Python da zero

Python fornisce diverse librerie e framework per creare un web crawler con facilità. I due principali metodi ampiamente utilizzati per lo scraping web sono:

- Web crawler utilizzando la libreria BeautifulSoup di Python.

- Web crawler utilizzando il framework Scrapy di Python.

Prima di entrare nella parte di codifica, discutiamo alcuni pro e contro di ogni metodo.

I pro di Scrapy

- È un framework di scraping web e non una libreria Python.

- È open source.

- Le prestazioni sono più veloci rispetto ad altri metodi di scraping web.

- La comunità di sviluppo di Scrapy è vasta e potente rispetto ad altre comunità di scraping web.

I contro di Scrapy

- È leggermente più complesso rispetto ad altri metodi di scraping web.

- Contiene codice più pesante non adatto per progetti su piccola scala.

- La documentazione non è comprensibile in modo apprezzabile per i principianti.

I pro di BeautifulSoup

- BeautifulSoup è facile da usare e adatto ai principianti.

- Perfetto per piccoli progetti poiché è leggero e meno complesso.

- Documentazione facilmente comprensibile per i principianti.

I contro di BeautifulSoup

- È più lento rispetto ad altri metodi di scraping web.

- Non può essere ampliato a progetti più significativi.

- Ha una dipendenza esterna da Python.

Come costruire un web crawler con BeautifulSoup di Python

In questo metodo, cercheremo di scaricare dati statistici riguardanti gli effetti del Coronavirus dal sito web di Worldometers. Si tratta di un tipo di applicazione molto interessante che può essere utile per il data mining e lo storage con lo scraping web.

Codice di riferimento:

Scopri di più su Beautiful Soup nel web scraping e sulla sua alternativa.

Come creare un web scraper usando Scrapy di Python

In questo semplice esempio, stiamo cercando di estrarre dati da Amazon. Poiché scrapy fornisce un proprio framework, non è necessario creare un file di codice. Possiamo ottenere i risultati desiderati inserendo semplici comandi nell’interfaccia della shell di scrapy.

1. Configurazione di Scrapy

- Apri il prompt dei comandi.

- Esegui il comando:

- ” pip install scrapy “

- Una volta installato scrapy, digita il comando:

- ” scrapy shell “

- Questo avvierà l’interfaccia della riga di comando di scrapy all’interno del prompt dei comandi.

2. Recupero del sito web

- Usa il comando fetch per ottenere la pagina web di destinazione come oggetto di risposta.

- fetch(‘https://www.amazon.in/s?k=headphones&ref=nb_sb_noss’)

- Noterai che la riga di comando restituirà True.

- Ora apri la pagina web recuperata usando il comando:

- view(response)

- Questo aprirà la pagina web nel browser predefinito.

3. Estrazione dei dati dal sito web

- Fai clic con il tasto destro del mouse sul primo titolo del prodotto sulla pagina e seleziona ispeziona elemento.

- Noterai che ha molte classi CSS associate ad esso Copia una di esse negli appunti. Esegui il comando sulla shell di scrapy :

- response.css(‘class_name::text’).extract_first()

- Noterai che il comando restituirà il nome del primo prodotto presente sulla pagina.

- Se questo è riuscito, procedi con l’estrazione di tutti i nomi dei prodotti.

- response.css(‘class_name::text’).extract()

- Noterai che verrà visualizzata la lista dei prodotti sulla pagina nell’interfaccia della shell di scrapy.

Puoi trovare ulteriori informazioni su Scrapy e le sue alternative di scraping web.

Lo scraping web è un metodo utile quando si tratta di acquisire informazioni gratuitamente da database accessibili pubblicamente. Agevola il lavoro manuale che si inserisce nel download di dati in blocco. Se addestrato correttamente, può dimostrarsi una competenza molto utile per scopi commerciali e professionali.

Parole Finali

Ci sono numerosi metodi di scraping web, di cui due sono spiegati in questo articolo. Ogni metodo ha i suoi pro e contro, il suo livello di facilità e complessità dell’applicazione. Il metodo che dovrebbe essere utilizzato per un determinato progetto varia con i parametri del progetto. Pertanto, può essere necessario per uno sviluppatore imparare più metodi per lo scraping web. Spero che questo articolo rafforzi la tua comprensione del web scraping e ti ispiri nel tuo viaggio di scraping web.